見極めるべきは「AIの限界」と「人の長所」

セキュリティにおけるAIとの協働とは

2022/04/05

サイバーセキュリティ分野では、攻撃側、防御側の双方で AI が活用されるようになっている。果たしてAI によってサイバーセキュリティは強固になっていくのだろうか、それとも大きな被害を招いてしまうのか。

情報通信セキュリティの専門家である、国立情報学研究所 サイバーセキュリティ研究開発センターの安藤 類央氏が、さまざまな事例を交えながらAIとの協働について語った。

* 高度化するAIを、人はどう活用するべきなのか

最初に安藤氏はカーネギーメロン大学のチームによる「Mayhem」について触れた。

MayhemはDARPA(米国防総省高等研究計画局)主催の「自律的なコンピューターウエアによるハッキング大会」で2016年に優勝したソフトウェアだが、AI自身で脆弱性を見つけて対処する能力を持つ。サイバー攻撃が自動化される世界になりつつあるのだ。

「AIにできないことは少なくなっています。最近のビジネス向けSNSや求人サイトでは、AIが企業と求職者をマッチングし、人材の調達を自動化しています。他にも極端な例を挙げると、金融資産の収奪や軍事力の増強も自動化できると言えます」(安藤氏)

2015年にプロ棋士を破ったAI囲碁ソフト「AlphaGo」の名前を覚えている人も多いのではないだろうか。その後継プログラム「AlphaZero」は、2017年にAIチェスソフトのチャンピオン「Stockfish」に勝利した。

AlphaZeroが学習にかけた時間は、わずか4時間にすぎないという。

安藤氏によるとAlphaZeroは、人間が学習させるのではなく、AI同士で学習するアプローチをとっている。

このような、人間を排除して発達するAIが社会に浸透すると、AIをどう開発するかではなく、どう運用・管理するかが問題になってくる。

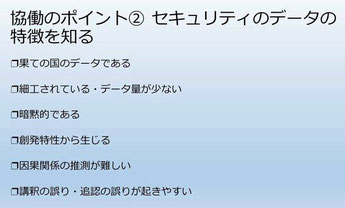

安藤氏は、人がAIと協働していくには、「AIの限界」「セキュリティのデータの特徴」「人間の長所」の3点を押さえることが大切だと語る。

* 機械は賢くなるほどに制御が難しくなる

サイバーセキュリティにおいて、悪意のあるプログラムを完全に防げるものが完成すれば、サイバーセキュリティビジネスはなくなるはずである。

しかし安藤氏は、現在、機械は人間の「悪意」が理解できないため、マルウェアを完璧に防ぐ機械を作れないと指摘する。

AIの限界の1つ、「完全自律が難しい」について安藤氏は、

「AIは賢くなればなるほど制御が効かなくなります。

一方でシンプルにすると融通が利かなくなる。AIはこのトレードオフから逃れられないため、完全自律が難しいのです」と述べた。

完全自律と言えば、自動車の自動運転をするかもしれないが、完全自律の自動運転技術は現時点で確立されていない。

現在はあくまでも人の運転を支援する技術であり、最終的な判断は人に委ねられる。

通常、プログラムの制御はIF(場合分け)を使って実装するが、自動運転ではあまりに多くの場合分けが発生するため、大量のコードを書かなければならず、現実的ではない。

全ての IFを実装することが困難なため、人間の判断や行動をAIで予測をする方向で制御の研究が進んでいるのだ。

安藤氏は、「もし完全な自動運転を実現するなら、自動運転に合わせて都市を大きく変える必要がある」と、掃除ロボット「ルンバ」で有名なiRobotの創業者、ロドニー・アレン・ブルックス氏の言葉を引用してAIの自律の難しさを示した。

* 感情や常識がないAIはフェイクニュースを見抜けない

AIの限界の2つ目である「意識・感情(身体)がない」について、安藤氏はFacebookに実装されているヘイトコンテンツのフィルタリングを例に説明した。

自然言語処理に多大な投資を行ってきたフェイスブック(現Meta社)でさえ、人間の皮肉や“ほのめかし”の意図は判別できず、フェイクニュースを完全にはフィルタリングできていないという。

安藤氏は、2014年にイギリスの緊急搬送現場で起きたエピソードも紹介した。

同国では、救急車を呼ぼうと電話をかけてきた人に対し、係員が聞き取った容態をソフトウェアに入力し、そのソフトウェアに救急車を出動させるか否かの判断を委ねることになっている。

このとき、ソフトウェアは「救急車は必要ない」との判断を下したが、残念なことにその患者は亡くなってしまった。

人間であれば患者の息遣いや口調などから、例外的な処理をすべきだと感じることができるが、ソフトウェアには細かな状況把握ができず、患者が命を落としてしまったのだ。

3つ目の限界「常識・創造性がない」については、2013年にシリアの電子軍がAP通信のTwitterをハッキングした事件を挙げた。シリアのハッカーが投稿した、「ホワイトハウスで爆発があり、バラク・オバマ大統領(当時)が負傷した」との虚偽ツイートに、HFT(アルゴリズムを用いた超高速取引)のAIが反応し、大量の株を売りに出し、わずか3分で1,360億円の損害を出した。人であれば常識的に考えた判断ができるが、AIにはできなかったのだ。

*「人間の長所」を知ることが、AIとの協働のポイント

AIの限界を説明した安藤氏は、続いてセキュリティのデータが持つ特性について話した。

人間の血液や体重の数値は3倍や4倍に跳ね上がることはないが、インターネットのトラフィックは一気に数倍になる。

セキュリティのデータも同様で、精度の高いシステムを入れれば攻撃やインシデントを防げるかもしれないが、ひとたび事故が起こると、被害が以前の数倍になる。危機が起こりにくくなる一方で、起きた被害はより深刻になっているのだ。

また、セキュリティのデータは暗黙的に散在する。

テロリストが「明日決行だ」と送ったメッセージには、「テロを」が明示されていないため、即座に判断することは難しい。

AIには因果関係の予測ができず、細かな情報を結びつけてインシデントを未然に防ぐことはできないのだ。

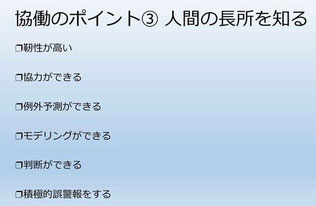

このような困難さはあるものの、人間の長所を知ることでAIの弱点は補えると安藤氏は示唆する。

人間の長所の1つは「靭性(じんせい)が高い」こと。粘り強く臨機応変に対処できることだ。

コンピューターはダイヤモンドに近く、剛性があるものの、フェイクニュースを疑わなかったHFTのように、失敗したときの損害が大きい。

「人はヒスイやコンクリートに近く、粘り強くて柔軟に組み合わせることができる。人は柔軟に人と協力でき、十分な情報がないときには想像力で補うこともできる」と安藤氏は話す。

AIは予測が得意だが、リスクテイクを伴う判断は苦手だ。

一方で、人は決断を下すことができる。今後データサイエンスが普及していくと、AIの利用料は安くなることが予想される。

その代わりに、決断(人間的な判断)を下す力は高い価値を持つと安藤氏は言う。

あくまでも人間が中心であり、AIは周辺だ。

「たとえAIやシステム、ツールが立派でも、柔軟かつ大規模に協力するチームのほうがより高価値です。偉大な建造物であるエジプトのピラミッドも、高度な数学によってできたイメージもありますが、非常にたくさんの人が協力したからこそできあがりました」(安藤氏)

最後に安藤氏は、これからのサイバーセキュリティに求められる人材について次のようにコメントした。

「これからは人の感情(攻撃者の気持ち)を知ることが重要です。AIは憎しみや恐怖がわからないので、これを知ると臨機応変にプロファイリングや対処ができます。また、人工知能のチューニングなど、システムを維持するための『手入れ』が好きな人、柔軟にタスクを変えて協力できる『風まかせ』な人も求められていくでしょう」

<参考文献>

・「スーパーインテリジェンス 超絶AIと人類の命運」 ニック・ボストロム (著), 倉骨 彰 (翻訳) 日本経済新聞出版 2017年11月

・「人工知能のアーキテクトたち ―AIを築き上げた人々が語るその真実」Martin Ford (著), 松尾 豊 (監修), 水原 文 (翻訳) オライリージャパン 2020年8月

・「ディープラーニング 学習する機械 ヤン・ルカン、人工知能を語る」 ヤン・ルカン (著), 松尾 豊 (翻訳, 監修), 小川 浩一 (翻訳) (KS科学一般書)講談社 2021年10月

・「WE ARE DATA アルゴリズムが「私」を決める」 ジョン・チェニー=リッポルド (著), 武邑 光裕(解説) (その他), 高取 芳彦 (翻訳) 日経BP 2018年4月

*** 皆さん、お忙しいとは思いますが、ご意見・ご感想など 『

※ メール・BLOG の転送厳禁です!! よろしくお願いします。

コメントをお書きください